RC 발진기를 보면 먼가 항상 증폭기나 비교기가 들어가는 느낌..

순수하게(?) R/C 만으로 LED를 깜박일순 없나?

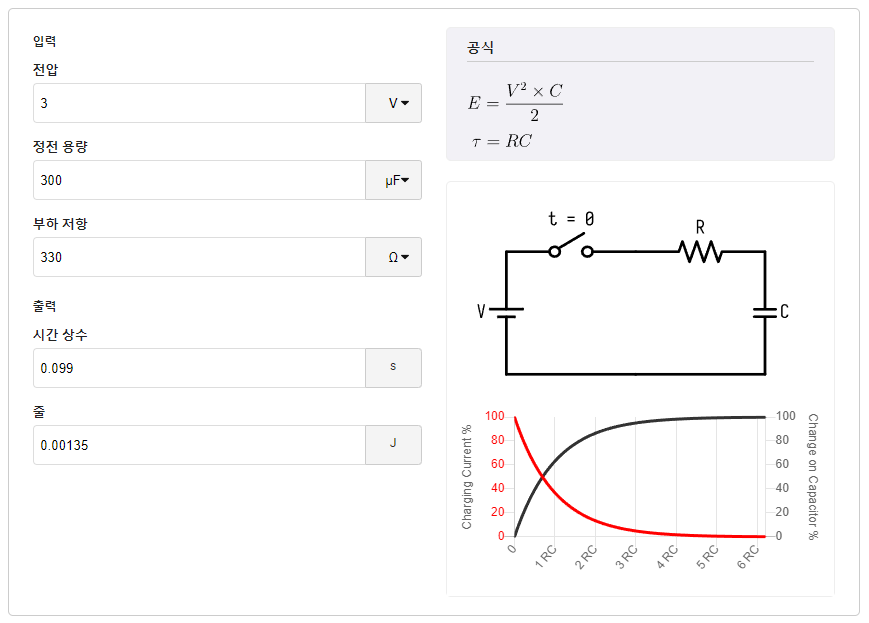

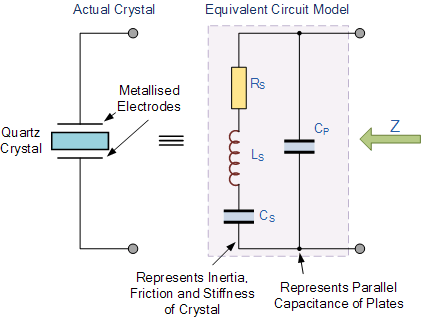

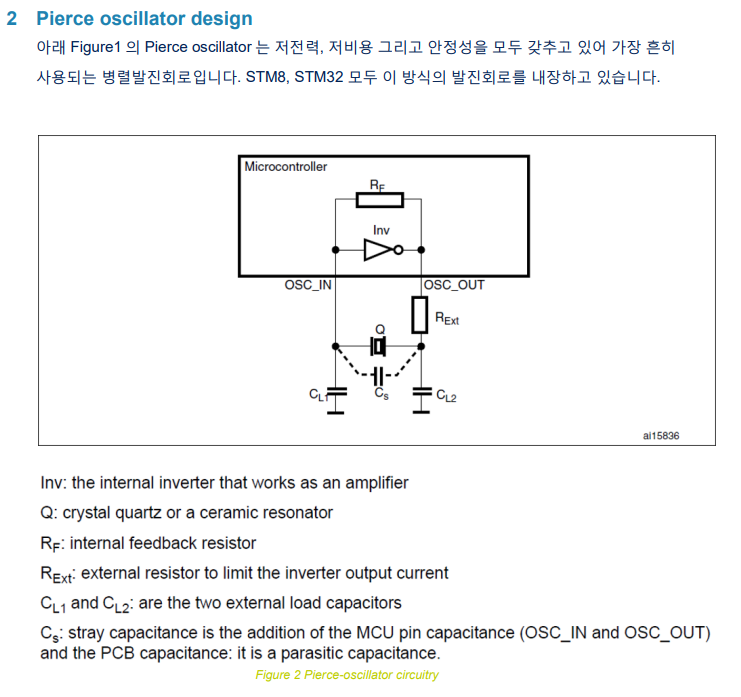

| 1. RC 귀환 발진기 (RC Feedback Oscillator) ㅇ 기본 원리 - 커패시터(C)와 저항기(R)를 이용한 충전/방전 회로의 충전/방전 주기 조절에 의해, - 주기적인 파형(정현파)을 만듬 ㅇ 구현 원리 - RC 위상천이회로 및 증폭기 회로구성을 통한, 정귀환 효과를 이용하여 정현파 발진을 도모함 |

[링크 : http://www.ktword.co.kr/test/view/view.php?m_temp1=5257]

[링크 : https://en.wikipedia.org/wiki/RC_oscillator]

[링크 : https://www.electronics-tutorials.ws/oscillator/crystal.html]

+

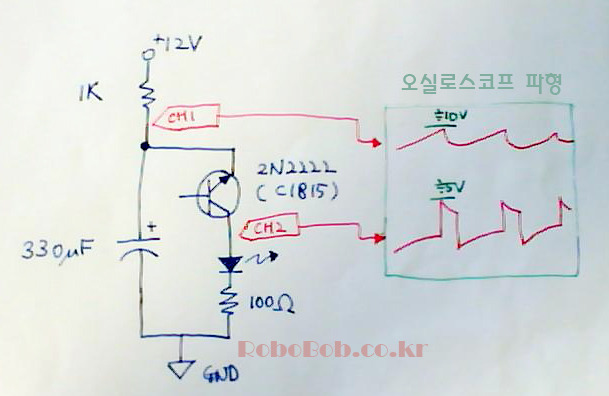

TR 1개 들어갔다고 신기해 하는거 보면.. RC 만으로는 불가능 한건가 싶기도 하고?

[링크 : https://robobob.tistory.com/3]

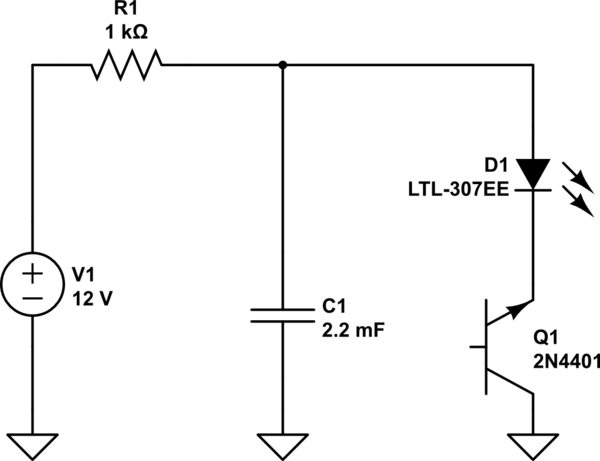

2N4401은 찾아보니 양극성 트랜지스터라고 나온다.

[링크 : https://electronics.stackexchange.com/questions/254845/how-to-make-blinking-led-without-using-any-ic]

'embeded > 전자회로' 카테고리의 다른 글

| 다이오드, 트랜지스터 (0) | 2023.10.18 |

|---|---|

| tr을 구매해볼까나.. (0) | 2023.10.18 |

| 오실로스코프 파형 - 캐패시터 (0) | 2023.10.17 |

| 오실로스코프 파형 - 저항 (0) | 2023.10.17 |

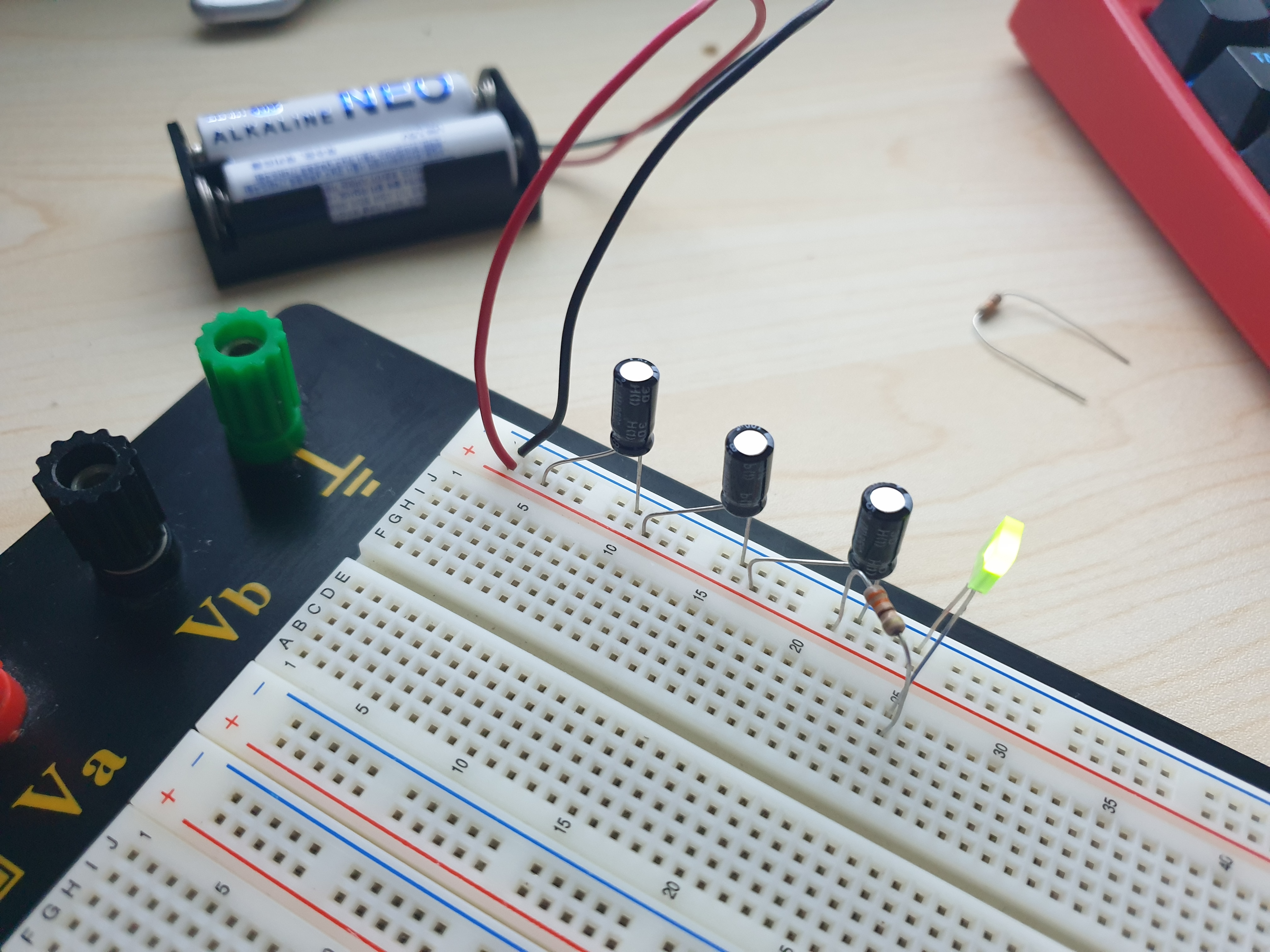

| 저항-캐패시터-LED 로 깜박이기 실패 (0) | 2023.10.15 |