22.04 시대에 18.04라니.. 긴 한데

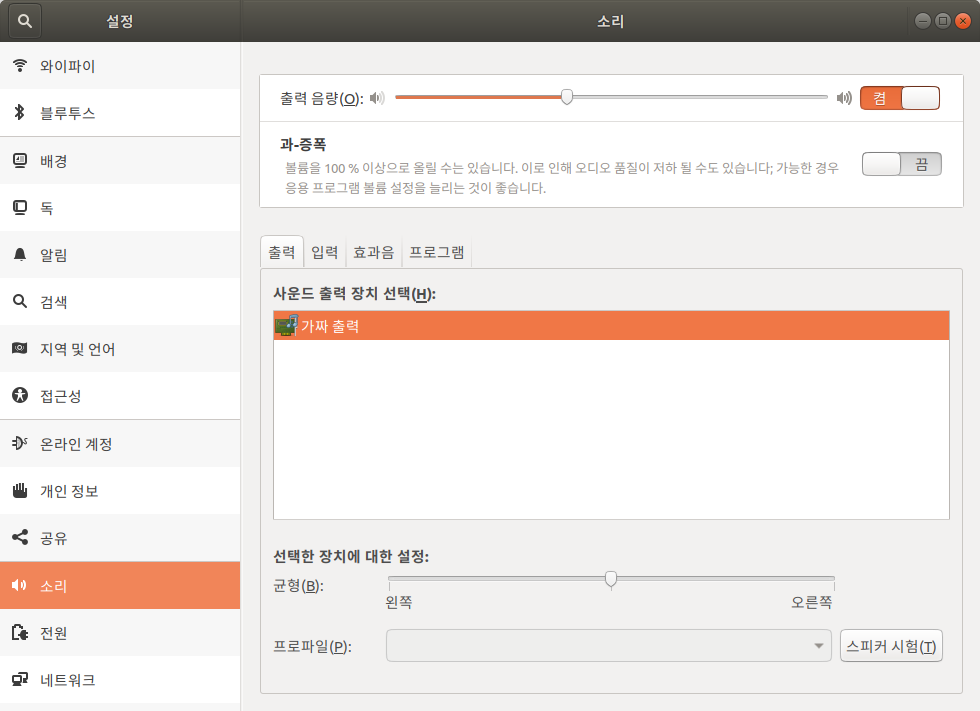

아무튼 gqrx 틀어 보니 가짜 출력(fake? dummy?) 라고 나오길래 찾아보니

아래의 모듈이 없어서 그렇다는데, 실행하고 나니 아래와 같이 헤드폰으로 잘 나온다.

| $ sudo modprobe snd-hda-intel |

[링크 : https://www.linuxuprising.com/2018/06/fix-no-sound-dummy-output-issue-in.html]

생각해보니.. rtl-sdr 관련 /dev/dsp 이런거 해보려고 oss 설치했던게 생각이 나네 -_-

젠장 역시나!!

| /etc/modprobe.d$ grep -rni intel . ./blacklist-modem.conf:3:# blacklist snd-intel8x0m ./blacklist-framebuffer.conf:13:blacklist intelfb ./alsa-base.conf:31:options snd-intel8x0m index=-2 ./oss4-base_noALSA.conf:83:blacklist snd-hda-intel ./oss4-base_noALSA.conf:94:blacklist snd-intel8x0 ./oss4-base_noALSA.conf:95:blacklist snd-intel8x0m ./blacklist.conf:21:# snd_intel8x0m can interfere with snd_intel8x0, doesn't seem to support much ./blacklist.conf:23:blacklist snd_intel8x0m |

'프로그램 사용 > rtl-sdr' 카테고리의 다른 글

| gqrx, gnu radio, rfcat (0) | 2024.08.21 |

|---|---|

| rtl sdr 다중 채널 디코딩 (0) | 2022.08.30 |

| RTL-SDR 11시 땡! (0) | 2022.01.07 |

| gqrx 오디오 스트리밍 (0) | 2022.01.07 |

| rpi gqrx (0) | 2022.01.07 |