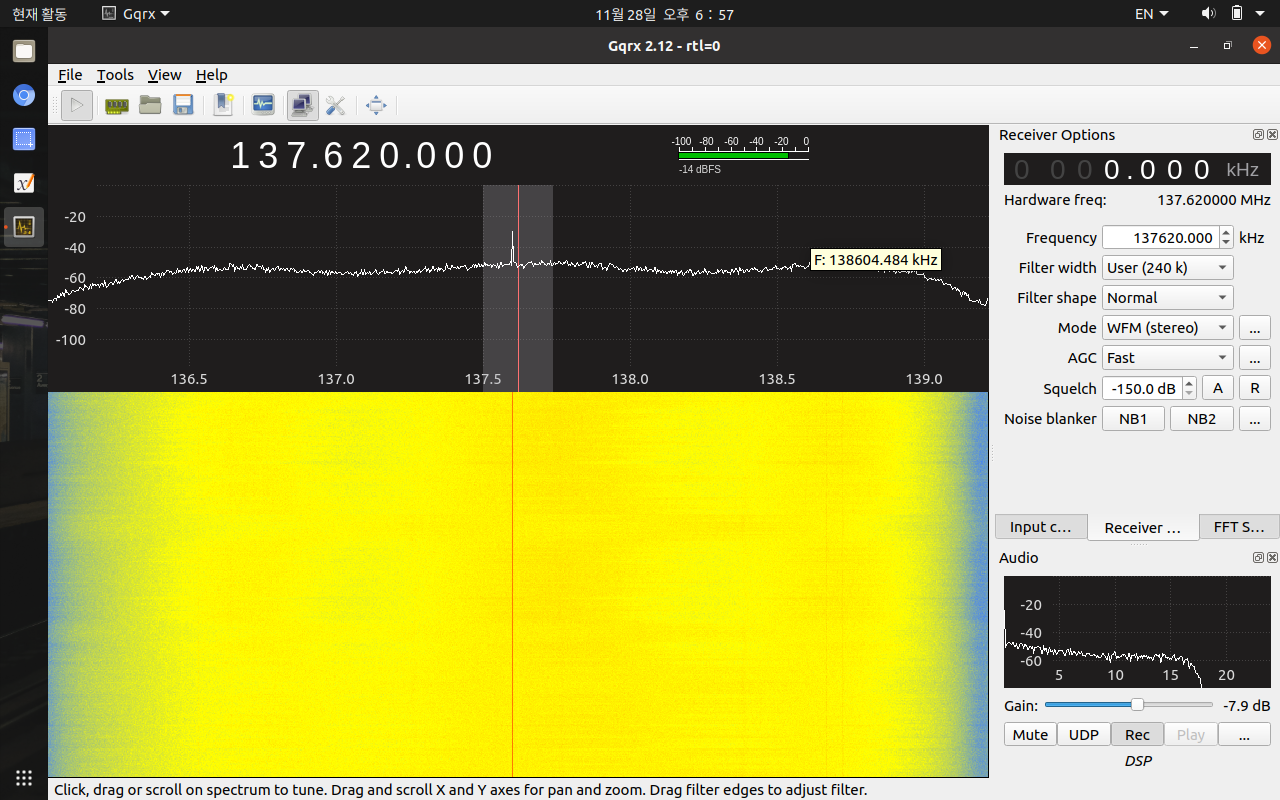

gnu 라디오를 이용하여 소켓으로 주고 받고 해당 데이터를 FFplay를 통해 재생하는 예제.

python으로 되어있어서 코드를 받아 분석을 해봐야겠다.

(이게 되면 DMB 채널이나 공중파 HDTV 디코딩 해볼 수 있으려나?)

[링크 : http://www.wu.ece.ufl.edu/projects/wirelessVideo/project/realTimeCoding/index.htm]

'프로그램 사용 > rtl-sdr' 카테고리의 다른 글

| rtl-sdr 신제품 도착!! (0) | 2021.12.09 |

|---|---|

| RTL-SDR FC0012 튜너 특성 (0) | 2021.12.07 |

| RTL-SDR로 김포공항 주파수 듣기 성공 (0) | 2021.12.07 |

| rtl sdr i,q branch? (0) | 2021.12.03 |

| 지름 재도전!! (0) | 2021.12.01 |