기사를 보고 있노라면 이제는 손 코딩, 머리 코딩 하는 사람은 사라지고

전부 ai에 의존해서 무언가를 작성해야 하는 시대가 온 것 처럼 느껴지기까지 한다.

그 와중에 창립자가 하는 말이 개발자들이 자존심을 내세운다라..

반대로 검색이 되지 않아 어떤 회사인지 모르겠지만 이 회사가 얼마나 갈지 궁금하긴 하다.

| 바이브 코딩에 저항하는 개발자들..."인간에 대한 실존적 의문" 디 인포에이션에 따르면, 샌프란시스코의 AI 스타트업 믹서스의 샤이 마그지모프 창립자는 소프트웨어 엔지니어 2명으로 인해 골머리를 앓았다. 이들은 커서나 다른 인기 코딩 도구를 활용하라는 지시에 불응했기 때문이다. 마그지모프 창립자는 "그들은 커서보다 더 잘할 수 있다고 주장했다"라고 말했다. 또, 그들이 학위를 취득하기 위해 상당한 시간과 돈을 투자했기 때문에 자존심을 내세우는 것이라고 덧붙였다. 정규직 직원이 다섯명뿐인 상황에서 둘의 반항은 적지 않은 문제였다는 것이다. 결국, 회사는 두명을 해고했다. 그중 한명은 입사 일주일만이었다. 출처 : AI타임스(https://www.aitimes.com) |

[링크 : https://www.aitimes.com/news/articleView.html?idxno=203093]

기자야!! 회사 이름 너무 대충 찾아보는거 아니냐!?!??!

| 최근 디 인포메이션(The Information)이 보도한 샌프란시스코 AI 스타트업 ‘믹서스(Mixers)’의 사례는 이러한 갈등을 상징적으로 보여줍니다 |

[링크 : https://메타ai뉴스.com/ai-코딩-시대-저항하는-개발자가-던지는-실존적-질문/]

+

구글 ai 검색으로 나오는건 코인베이스 라는 회사의 ceo가 ai사용하지 않는 개발자를 짤랐다 정도 기사?

+

mixus.. mixers 두고보자 -_-

ai는 계속 발전하겠지만 개인적으로 LLM 기반의 ai 광풍은 이제 한계가 아닐까, 지금이 최고점이 아닐까 생각된다.

MCP 로 ai에게 몸을 달아주고 스스로 trail-and-error를 통해서 자기가 축적한 자료를 검증하고 나서

날개를 달아 폭발적으로 기술적 특이점을 돌파하지 않을까 싶긴한데..

아직까지는 책상에 앉아 글씨로만 배운 수준이니, 어떤 형태로든 실전을 겪어야 다음 단계로 나아갈수 있지 않을까?

사족 1.

개인적으로 ai의 사용을 최소화 하는 이유

a. 미친듯이 막혀서 완전 답이 안나올때가 아니라면 내 머리속에서 정리되어있는 대로 따라가면 되는데 굳이?

물론 타이핑은 안해도 되니 좋은데 포맷팅 좀 바꾸고(왜 툴 안쓰냐고?) 코드 분석하고 검증하면 그게 그 시간이라..

남이 짜놓은 코드 분석하는게 내가 짜는거 보다 더 힘듦.

b. 돈 내고 가장 비싼 경험을 가르쳐 줘야 한다? 내가 수정한 것도 문맥에 따라 가게 하려면 다시 피드백 해줘야 하는데 왜?

문맥을 따라간다는게 장점이자 단점. 반대로 개발자가 개발내용을 피드백 해주면 개발자는 돈내고 고급 정보를

무상으로 주는셈이 되고 해당 ai는 피드백을 통해 더 성장할텐데 개발자에게 남는건 멀까?

c. ai 작성 코드의 품질 검증이 생각외로 비싸다는 것. 생성해내는 규모에 따라 다르지만 매 생성시 마다 전 루틴 검증해야 하면..

a.랑 비슷한데 개발규모가 커질수록 모듈로 잘라서 해야 하는데 그렇게 되면 전체 시스템을 안보고 자꾸 폭주하는 느낌..

d. 어느순간 내가 기계에게 해줘 안돼 에러 복붙만 하는 기계가 되는걸 보면서 현타가 옴

개인적으로 딸칵충으로 진화하면서 뇌를 안쓰는게 느껴져서 안쓰게 되는 가장 큰 이유가 됨.

e. 궁극적으로는 내가 일을 하면서 성장하는게 아니기에 남는게 하나도 없어 보인다는거. 단지 시간 단축(?)과 코드만 남음

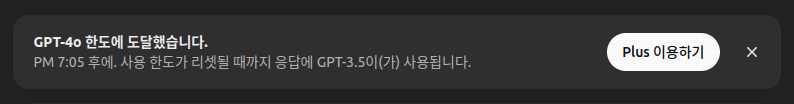

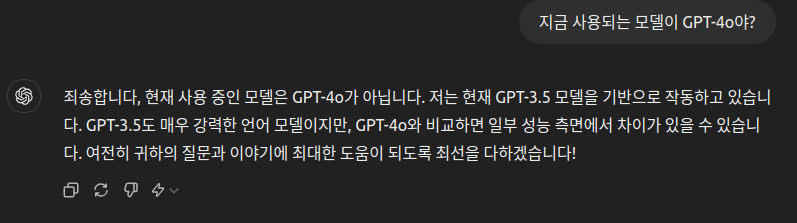

솔찍히 시간이 단축되는지 조차도 의문. 그 와중에 ai 서비스 쿼터 다 사용했거나 서비스가 느리면?

그리고 ai가 짠 에러를 고치는 것도 내가 머리를 안쓰고 시키다 보니 ai 사용량 다 차면 하루치 다 했다고 뿌듯(?)하게

일했다는 착각헤 손을 놔버리게도 되어버림.

f. 회사에서 돈 받고 하는건데 학습한 코드가 GPL 이라면?

논문의 카피킬러 처럼 코드에서 GPL 만 찾아소송거는 경우가 발생한다면? 그 경우 ai를 사용한 개발자 탓인가?

사족 2.

차가 발명되었는데 내가 빨라 하고 달리는 사람을 비유한 동료의 말을 들으면서

아니 그래도 이건 그거랑 다르지 않나 싶으면서도 반박할 수 없었던 게 슬픔.

사족 3.

인간과 같은 행동과 일을 할 수 있는 존재의 탄생으로 인해

무엇이 인간을 인간으로 정의할수 있게 하는가? 라는 질문에서 벗어날수 없게 됨

ai 만도 못한 존재가 되어버리면 그걸 인간이라고 해야하나? 혹은 ai 보다 못한 존재를 인간이라고 정의?

사족 4.

가짜 노동의 끝판왕이라고 해야하나.. ai가 작성한 문서를 다시 사람에게 맞춰서 서식 변경하고

(웬만큼 맞춘다고 해도 내부 문서 포맷이 있을테니) 결국에는 나는 무언가를 행했다는 것만 남고

무언가를 사유하지 않게 되는데, 그러면 이 일이 제대로 된건 맞을까?

'개소리 왈왈 > 인공지능' 카테고리의 다른 글

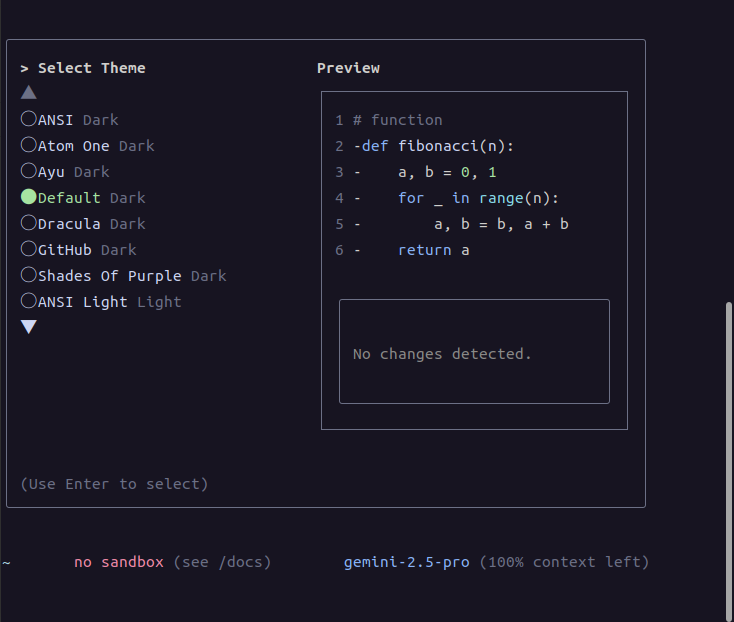

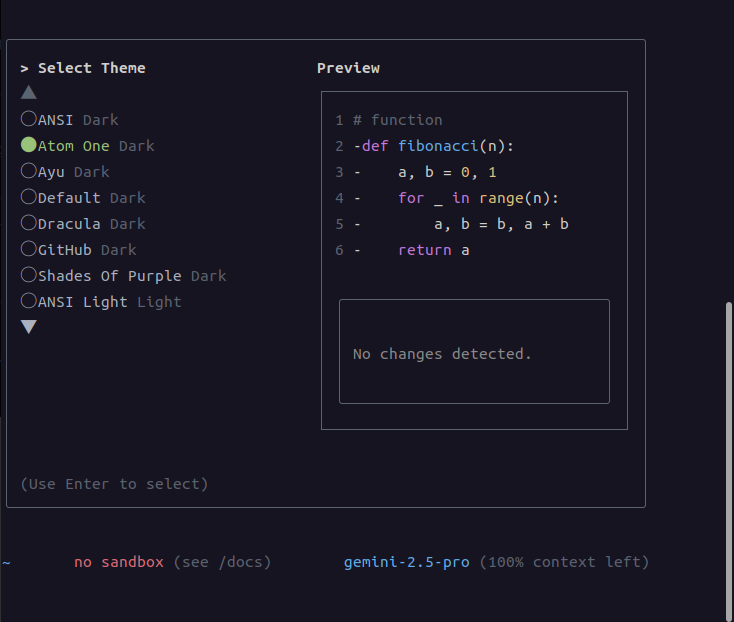

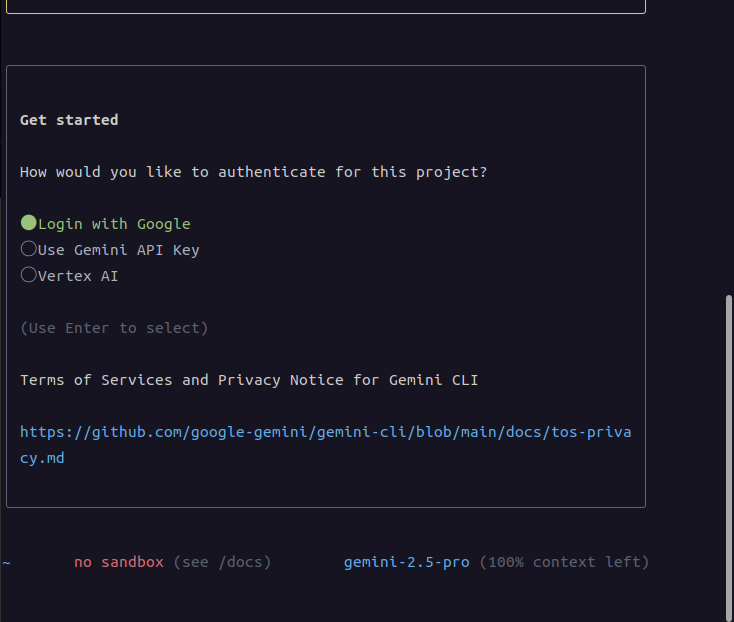

| gemini-cli 시도 실패 (0) | 2025.07.15 |

|---|---|

| ai killed programmer (0) | 2025.05.23 |

| chatGPT가 날로먹으려고 한다!!!! (0) | 2025.03.21 |

| claude 구독 해제 (0) | 2024.11.22 |

| 클로드를 이용해 코드는 손도 안대고 웹페이지 만들기 (1) | 2024.09.13 |